Elektryczny wszechświat

Artykuł po raz pierwszy w języku polskim ukazał się w dwumiesięczniku Nexus w numerze 153 (1/2024)

Tomasz Zaborowski

Copyright © 2023

NAUKA U PROGU REWOLUCJI

Każdy, kto na bieżąco śledzi postępy nauki, na pewno zauważył, że w ostatnich latach pojawia się coraz więcej artykułów mówiących o problemach w wyjaśnianiu nowych zjawisk przy pomocy starych i uznanych teorii naukowych. Coraz więcej obserwacji astronomicznych, wykopalisk archeologicznych czy badań laboratoryjnych wprawia w zakłopotanie specjalistów poszczególnych dziedzin nauki. I chociaż tak zwany „Gmach Ludzkiej Wiedzy” nadal wydaje się być solidnym monolitem, to jednak coraz bardziej wygląda na to, że w nauce nadchodzi gigantyczna rewolucja. Nadchodzące zmiany mogą być porównywalne chyba tylko z rewolucją kopernikańską.

Chociaż przewrót kopernikański był rewolucją intelektualną, która zmieniła radykalnie nasze widzenie całego kosmosu, to jednak nie miał on większego wpływu na rozwój wielu dziedzin nauki. Tymczasem zmiany które nadchodzą teraz, oprą się na zupełnie nowym paradygmacie, którego zasięg obejmie bardzo szeroki wachlarz dyscyplin naukowych.

Zacznijmy więc od słowa paradygmat. Pojęcie to wprowadził filozof Thomas Kuhn w swojej książce The Structure of Scientific Revolutions (Struktura rewolucji naukowych). Oznacza ono zbiór pojęć i teorii tworzących podstawy danej nauki. Według Kuhna dopóki obrany paradygmat pozostaje twórczy poznawczo (czyli pozwala formułować falsyfikowalne i prawidłowe przewidywania wyników nowych obserwacji i eksperymentów), dopóty nie ma powodów aby go kwestionować. Przykładem paradygmatu był na przykład Model Ptolemeusza. Przyjmował on Ziemię jako centrum wszechświata i opisywał ruchy ciał niebieskich w odniesieniu do nieruchomej Ziemi. Model ten sprawdzał się do momentu, w którym precyzja obserwacji pozwoliła astronomom zauważyć rozbieżności ich pomiarów z przewidywaniami. Rozbieżności te próbowano tłumaczyć istnieniem dodatkowych składowych ruchu planet zwanych epicyklami. Tymczasem Kopernik wykazał, że do wyjaśnienia ruchów planet nie potrzeba żadnych epicykli – wystarczy zmienić układ odniesienia. Można dyskutować, czy model Kopernika sam w sobie zasługuje na miano paradygmatu. Pewne jest jednak, że bez niego nie powstałaby teoria Newtona, która wraz ze swoim niezwykle skutecznym aparatem matematycznym, dała początek paradygmatowi grawitacyjnemu.

PARADYGMATY W KRYZYSIE

Grawitacja

Paradygmat grawitacyjny opiera się na założeniu, że w skali kosmicznej zachowaniem materii rządzi tylko grawitacja. To grawitacja ma być odpowiedzialna za powstawanie i kształt planet, to grawitacja ma wyzwalać energię termojądrową we wnętrzach gwiazd i tylko grawitacja utrzymuje gwiazdy w ramionach galaktyk. Sformułowane przez Newtona równania opisujące oddziaływanie dwóch mas pozwalały na daleko idące przewidywania ruchów planet i mniejszych ciał niebieskich. Z kolei precyzja pomiarów ich ruchu i położenia pozwalała na dokładną weryfikację tych przewidywań. Paradygmat ten sprawdzał się doskonale przez ponad 200 lat. Nic więc dziwnego, że przez ten czas uczeni zdążyli skonstruować na jego podstawie cały obraz kosmosu. To w oparciu o ten paradygmat już od wielu pokoleń budowane były (i nadal są) osiągnięcia i kariery całego naukowego establishmentu.

Pierwsze problemy paradygmatu grawitacyjnego pojawiły się wraz z obserwacjami pomiarów prędkości rotacji galaktyk. Prędkości te nijak nie pasowały do równań. Okazało się że gdy zsumujemy masy wszystkich gwiazd w galaktyce, to otrzymany wynik jest zbyt mały, by to grawitacja mogła utrzymać niektóre gwiazdy w ramionach galaktyk. Aby gwiazdy znajdujące się z dala od centrum galaktyki nie zostały wyrzucone siłą odśrodkową w przestrzeń międzygalaktyczną, potrzebna jest masa co najmniej 10 razy większa niż szacowana masa wszystkich widzialnych gwiazd w danej galaktyce!

Problem z paradygmatem nie polega na tym, że ogranicza on ogólne ramy naszego postrzegania i myślenia. Taka koncentracja ma przecież swoje zalety. Problem zaczyna się wtedy, gdy chcemy ratować paradygmat kosztem ważnych zasad wnioskowania naukowego.

Otóż dokładnie tak zrobiono, gdy paradygmat grawitacyjny stanął w obliczu kryzysu. Wówczas w celu ratowania starego modelu wymyślono, że w centrum galaktyki musi znajdować się obiekt, którego nikt wcześniej nie zaobserwował i który nazwano Czarną Dziurą. Założenie istnienia takiego obiektu stanowi jawne pogwałcenie tak zwanej brzytwy Ockhama, która w filozofii nauki jest odpowiednikiem zasady najmniejszego działania w fizyce. Zasada Ockhama mówi, że jeśli jakiś proces można wyjaśnić na wiele różnych sposobów, to najbardziej prawdopodobnym wyjaśnieniem jest to najprostsze i które nie wymaga wprowadzania do teorii wcześniej nie znanych bytów lub praw natury. Zasada ta została wymyślona właśnie po to, by wyeliminować wprowadzanie do naszych teorii takich rzeczy jak elfy, krasnoludki czy… czarne dziury.

Tymczasem w przeciągu 200 lat swojego istnienia paradygmat grawitacyjny z ogólnych ram przeistoczył się w mentalną pułapkę. Chociaż równania Newtona zastąpiono równaniami Einsteina, grawitacja pozostała nadal jedyną siłą rozważaną w skali kosmicznej.

W obliczu kryzysu wywołanego pomiarami prędkości rotacji ramion galaktyk, paradygmat grawitacyjny uratowano ignorując brzytwę Ockhama. Gdy zrobiono to raz (postulując istnienie czarnych dziur) i gdy spotkało się to z entuzjastycznym przyjęciem ze strony środowiska naukowego, nauka zeszła na manowce. W efekcie fizyka teoretyczna do dziś zajmuje się rozważaniem własności takich bytów, jak czarne dziury, ciemna materia i ciemna energia. Teoretycy wręcz prześcigają się w egzotyce swoich pomysłów. W międzyczasie nawet nie spostrzegli, że swoimi pracami rozwijają już tylko matematykę, nie zważając na problemy wynikające z fizycznej interpretacji wyprowadzanych przez siebie równań.

Teoria kwantowa

Dokładnie tak samo jest w fizyce kwantowej. Problem związany z pojawianiem się w jej równaniach wartości nieskończonych, zamiast powiedzieć fizykom, że coś jest nie tak z ich teorią, w praktyce podpowiedział im, że wystarczy zastosować matematyczny trik (chyba dla zmyłki nazwany renormalizacją – cokolwiek to znaczy) i nieskończoności znikają jak za dotknięciem czarodziejskiej różdżki. Biorąc pod uwagę, jak daleko uprawianie fizyki odeszło od przeprowadzania rzeczywistych eksperymentów, w zasadzie nie powinno nas wcale dziwić, że mimo ogromnego wysiłku całych rzesz naukowców, jak dotąd nie udało się stworzyć kwantowej teorii grawitacji. Co więcej, aparaty pojęciowe i matematyczne, jakimi posługują się teoretycy kwantowi i specjaliści od ogólnej teorii względności, wydają się nie do pogodzenia.

Przesunięcie ku czerwieni

W naukach o kosmosie do statusu paradygmatu urosło też założenie że tak zwane przesunięcie widma światła obiektów kosmicznych w stronę czerwieni lub fioletu jest w całości wynikiem efektu Dopplera. Przyjęcie tego założenia doprowadziło między innymi do stworzenia atrakcyjnej z religijnego punktu widzenia teorii Wielkiego Wybuchu. Wśród kosmologów teoria ta uzyskała wręcz status dogmatu. Niestety, traktowanie efektu Dopplera jako jedynego wyjaśnienia przesunięć widma światła emitowanego przez obiekty kosmiczne, z czasem doprowadziło do wielu wręcz szokujących wniosków obserwacyjnych. Przykładem niech będą tak zwane kwazary, które zdaniem astronomów są obiektami wprost absurdalnie jasnymi (niektóre świecą jaśniej niż całe galaktyki), a niektóre z nich mają się obracać wokół własnej osi tysiące razy na sekundę!

[BREAK]

Uniformitaryzm

Paradygmatem, który funkcjonuje w naukach nie tylko o kosmosie, ale również o Ziemi jest Uniformitaryzm. Sprowadza się on do stwierdzenia, że wszystkie czynniki kształtujące zarówno wszechświat, jak i układ słoneczny i naszą planetę, występują od bardzo dawna i możemy je obserwować do dziś. Do tych czynników należą: grawitacja, tektonika płyt kontynentalnych, wulkanizm, sedymentacja, erozja i czynniki biologiczne. Chociaż geolodzy przyznają, że raz na jakiś czas Ziemię nawiedzają globalne kataklizmy, to ich zdaniem kataklizmy te są zawsze wywołane uderzeniami różnej wielkości meteorytów. Poza wywołaniem zmian klimatycznych i towarzyszących im masowym wymieraniom gatunków, uderzeniom tym nie przypisuje się w geologii większej roli. Geolodzy są bowiem przekonani, że najważniejsze i zachodzące na największą skalę procesy (tektonika płyt odpowiedzialna za procesy wypiętrzania gór, sedymentacja, czyli osadzanie się warstw, oraz erozja, czyli wywołany czynnikami środowiska nieustanny proces rozpadu) przebiegają w bardzo powolnym tempie i dopiero akumulacja ich efektów na przestrzeni niewyobrażalnie długich okresów czasu sprawia, że ich skutki są tak spektakularne.

A jednak nie wszyscy uczeni w pełni zgadzają się z modelem powolnych zmian. Zwolennicy katastrofizmu uważają, że powstawanie największych struktur geologicznych jest wynikiem najgwałtowniejszych procesów. Ich zdaniem powierzchnia naszej planety została ukształtowana głównie w efekcie różnego rodzaju kataklizmów, których natura do dziś nie jest wyjaśniona ani nawet nie była dostatecznie szczegółowo badana.

Geolodzy wiedzą, że erozja czy sedymentacja mogą zachodzić w dość szerokim zakresie prędkości. Jednak gwałtowne epizody błyskawicznego działania tych procesów kojarzą im się raczej ze zdarzeniami o zasięgu lokalnym i nie mającymi większego wpływu na geologię. Powodem, dla którego nie brano pod uwagę, że na przykład sedymentacja i erozja mogą zachodzić w sposób gwałtowny na ogromną skalę, był fakt, że w paradygmacie grawitacyjnym pewne procesy, chociaż są teoretycznie możliwe, to jednak nie mogą zachodzić w warunkach panujących dzisiaj na Ziemi. Żeby zrozumieć, dlaczego geologia poszła takim a nie innym tropem, musimy wziąć pod uwagę, że większość teorii obowiązujących w geologii do dziś zostało sformułowanych jeszcze w wiekach XVII, XVIII i XIX. W XX wieku dołączyła do nich tylko teoria płyt tektonicznych. Nie powinno więc nas dziwić, że teorie te nie brały pod uwagę czynników, których istnienie odkryliśmy dopiero dzięki postępowi technicznemu (np. elektryczność, istnienie wiatru słonecznego, plazmosfery czy magnetosfery). Z drugiej strony geolodzy nie powinni tak kurczowo trzymać się starych założeń. Od tamtej pory dokonano wielu nowych odkryć, których znaczenie jest wręcz fundamentalne, a które nigdy nie stały się przedmiotem poważnej dyskusji. Należą do nich:

1. Udokumentowane przykłady „natychmiastowej” fosylizacji. Należą do nich między innymi.

a. Skamieniały pień drzewa ściętego jeszcze za życia piłą mechaniczną (zostało ono ścięte przez techników w celu uzyskania wolnej przestrzeni na pociągnięcie linii wysokiego napięcia).

b. Skamieniałe mięczaki z zachowaną strukturą komórkową.

c. Skamieniałe ryby z zachowanymi w skrzelach strukturami niezapadniętych naczynek krwionośnych, które normalnie zapadają się niemal natychmiast po ustaniu akcji serca.

2. Odkrycie dowodów na natychmiastowe zlodowacenie, o którym świadczą znaleziska całkowicie zamarzniętych (czyli zamarzniętych w bardzo krótkim czasie) mamutów z jeszcze nie połkniętą roślinnością w pyskach, która na dodatek nie mogła rosnąć w tundrze.

3. Odkrycie spontanicznej separacji i jednoczesnego depozytu warstw różnych kruszyw pod wpływem zmiennego pola elektromagnetycznego (eksperymenty laboratoryjne).

Odkrycia tego typu są przez główny nurt nauki aktywnie zwalczane lub ignorowane. Dzieje się tak, ponieważ w sposób bezdyskusyjny podważają one uniformitarystyczne założenia, na których opierają się teorie przedstawiane w podręcznikach szkolnych.

Pomimo początkowych oporów teoria tektoniki płyt szybko uzyskała wśród geologów niemal status dogmatu. Być może stało się tak dlatego, że doskonale wpisuje się ona w przyjęty jeszcze w XIX wieku paradygmat ciągłych powolnych zmian. Dziś wszelkie próby podważania tej teorii są wyśmiewane lub cenzurowane przez establishmentowych wydawców. Fakt potwierdzenia pomiarów wykazujących rozszerzanie się dna oceanicznego nie musi jednak świadczyć o wzajemnym przemieszczaniu się płyt kontynentalnych. Niektórzy naukowcy zwrócili bowiem uwagę, że dokładnie taki sam efekt może być wywoływany powiększaniem się średnicy naszej planety. (Według nich płyty kontynentalne mogły kiedyś pokrywać całą powierzchnię Ziemi, której ciągłe rozszerzanie się powoduje ich wzajemne oddalanie).

Jedno z twierdzeń teorii tektoniki płyt mówi o tym, że trzęsienia ziemi są wynikiem gwałtownego wyzwolenia energii nagromadzonej w skałach dwóch przemieszczających się względem siebie płyt. Wyzwolenie tej energii następuje w momencie, gdy naprężenia wywołane wzajemnym tarciem przekraczają wytrzymałość skał i dochodzi do gwałtownego ich odkształcenia wywołującego drgania sejsmiczne. O nieadekwatności tego wyjaśnienia świadczą wyniki pewnych pomiarów. Wynika z nich, że grubość płyt kontynentalnych może dochodzić do maksimum 100 km (grubość płyt oceanicznych jest znacznie mniejsza i waha się w granicach 10–15 km). Tymczasem największa zanotowana głębokość źródła fal sejsmicznych wynosi nieco ponad 700 km! Przecież na takich głębokościach nie może być mowy o sztywności skał i nagromadzeniu energii tarcia. Wniosek jest prosty, ale nie usłyszycie go z ust żadnego „szanującego się” geologa. Teoria tektoniki płyt nie wyjaśnia przyczyn trzęsień ziemi. W rzeczywistości okazało się, że trzęsienia ziemi są skorelowane z aktywnością słoneczną i prawdopodobnie są wynikiem wyładowań elektrycznych zachodzących głęboko pod powierzchnią Ziemi.

PARADYGMAT ELEKTRYCZNY

Uwagi ogólne

By zrozumieć i w pełni uświadomić sobie znaczenie tego typu odkryć, potrzebna jest zmiana perspektywy oglądu zjawisk, którą daje nowy paradygmat. Paradygmat ten jest w swoim założeniu bardzo prosty i sprowadza się do stwierdzenia, że oddziaływaniem, które rządzi światem we wszystkich skalach jest oddziaływanie elektryczne.

W tym momencie trzeba zwrócić uwagę, że siła przyciągania elektrostatycznego pomiędzy dwiema naładowanymi cząstkami jest silniejsza od siły grawitacji aż 1039 (10 do 39 potęgi) razy! Obydwie siły są proporcjonalne do ilości cząstek i mają dokładnie taki sam zasięg, a więc proporcja różnicy siły jest taka sama bez względu na odległość między oddziałującymi cząstkami.

Dlaczego więc wszechpotężne oddziaływania elektryczne nie były i nie są brane pod uwagę w astronomii? Nie były, ponieważ w czasach Newtona nie były znane, i nie są, ponieważ uważa się, że obiekty makroskopowe, czyli składające się z ogromnej ilości cząstek, są elektrycznie obojętne. Dlaczego? Ponieważ w przeciwieństwie do grawitacji, oddziaływanie elektryczne jest dwojakiego rodzaju, czyli cząstki mogą się przyciągać (przeciwne ładunki) albo odpychać (te same ładunki). Dzięki temu zbiory różnie naładowanych elektrycznie cząstek mogą być elektrycznie zrównoważone (mogą zawierać dokładnie tyle samo protonów co elektronów), a przez to nie oddziałują elektrycznie.

Możliwość, że ciała niebieskie mogą posiadać ładunek elektryczny odrzucono ze względu na prace Sydneya Chapmana (1888–1970). Ten wpływowy brytyjski matematyk i geofizyk stworzył teorię, według której zorze polarne miały być wynikiem interakcji górnych warstw atmosfery z ziemskim polem magnetycznym. Wyśmiewał prace Kristiana Birkelanda, który prawidłowo wydedukował, że zorze nie są wywołane przez ziemskie pole magnetyczne, ale przez wiatr słoneczny. (Chapman w końcu zaakceptował wyjaśnienie Birkelanda, uznając je… za swoje).

Kristian Birkeland (1867–1917)

Chapman był świetnym matematykiem. Analizując stworzony przez siebie matematyczny model przepływu gazów w przestrzeni kosmicznej zauważył, że wprowadzenie do niego oddziaływań elektromagnetycznych mocno go komplikuje. Odrzucenie tego typu oddziaływań uzasadnił stwierdzeniem, że w kosmosie elektrony odpychają się, a to sprawia, że natychmiast się rozpraszają nie wywołując żadnych efektów. Autorytet Chapmana w połączeniu z wygodą obliczeń w jego modelu sprawiły, że astronomowie nie biorą pod uwagę oddziaływań elektrycznych do dziś. Dzieje się tak, mimo iż Hannes Alfven, który podczas akceptacji swojej Nagrody Nobla (w roku 1970 za stworzenie magneto-hydro-dynamiki) ostrzegł astronomów przed ignorowaniem tych oddziaływań, twierdząc, że zaprowadzi to astronomię i kosmologię w ślepą uliczkę.

Hannes Alfén (1908–1995)

On sam już nieco wcześniej zauważył, że to dynamika plazmy, a nie dynamika obojętnego gazu jest kluczem do rozszyfrowania kosmicznych zagadek. Zainspirowany mocą nowej perspektywy w wyjaśnianiu zjawisk kosmicznych wpadł na rewolucyjny pomysł, zgodnie z którym „obserwowana obecność kablopodobnych struktur (prądów Birkelanda) w plazmie, daje powód do rysowania diagramów obwodów elektrycznych dla zjawisk elektromagnetycznych w kosmosie i do rozmawiania o nich językiem elektrotechniki”. Ta idea stała się jednym z fundamentów rozwoju nowej dziedziny nauki – kosmologii plazmowej.

Chociaż status kosmologii plazmowej jako odrębnej dziedziny nauki został uznany przez IEEE (Institute of Electrical and Electronics Engineers – Instytut Inżynierów Elektryków i Elektroników), to jej osiągnięcia są przez astronomów ostentacyjnie ignorowane. Nie da się bowiem pogodzić astronomii opartej na grawitacyjnym oddziaływaniu obojętnych gazów z modelem opartym na dynamice plazmy. To są diametralnie różne mechanizmy zachodzenia omawianych procesów. Argumentem przemawiającym za modelem plazmowym jest to, że w celu wyjaśnienia własności jakiegokolwiek obiektu astronomicznego nie wymaga on istnienia żadnych niewidzialnych bytów ani wydumanych procesów, których nie da się odtworzyć w laboratorium. Tymczasem astronomowie poza wspomnianymi wcześniej czarnymi dziurami, ciemną materią i ciemną energią, do wyjaśnienia wyników obserwacji przywołują również „akrecję”, która ma być procesem odpowiadającym za powstawanie gwiazd i planet. Polegać ma ona na grawitacyjnym zapadaniu się obłoków gazu, czemu towarzyszyć ma tworzenie obracających się tak zwanych dysków akrecyjnych. Astronomowie nie przejmują się wcale tym, iż nikt nie zaobserwował tego procesu w żadnym laboratorium. Do dobrego samopoczucia wystarczą im odpowiednio zaprogramowane symulacje komputerowe.

Chociaż kosmologia plazmowa oferuje ogromne bogactwo nowych interpretacji obserwowanych obiektów i zjawisk kosmicznych, to jest tylko jednym z wielu aspektów paradygmatu elektrycznego.

Otwarcie umysłu na możliwość posiadania przez ciała niebieskie ładunku elektrycznego pozwoliło Immanuelowi Velikovsky’emu dokonać wręcz monumentalnej syntezy naszej wiedzy. Udało mu się bowiem znaleźć kontekst nadający sens pozornie fantastycznym opisom zawartym w starożytnych dokumentach. W ten sposób Velikovsky przywrócił najstarszym znanym nam opowieściom walor – co prawda ograniczonego stopniem rozwoju kulturowego – ale jednak rzetelnego przekazu historycznego. Znaczenia tego zwrotu w myśleniu nie sposób przecenić.

[BREAK]

Velikovsky i zderzenia światów

W swojej wydanej w roku 1950 książce Worlds in Collision (Zderzenie światów) Velikovsky zadaje proste, ale jakże wnikliwe, pytanie: dlaczego w najstarszych przekazach wielu odrębnych kultur, główne i najpotężniejsze bóstwo utożsamiane było z planetą Saturn? Przecież większość ludzi nie jest w stanie znaleźć jej na niebie!

Immanuel Velikovsky (1895–1979)

Odpowiedź wstrząsnęła Velikovskym i wywróciła do góry nogami wpojoną mu w szkołach wizję świata. Zdał sobie wtedy sprawę, że starożytne przekazy stanowią historyczne świadectwo tego, że niebo naszych przodków wyglądało zupełnie inaczej niż nasze.

Jako jeden z dowodów Velikovsky wskazuje, że przed rokiem 3000 p.n.e., żadna kultura nie wspomina o planecie Wenus i że pierwsze o niej wzmianki opisują ją jako niezwykłej urody kometę, a nie planetę. Na podstawie tłumaczeń starożytnej literatury Velikovsky wywnioskował później, że Ziemia była kiedyś częścią układu, w którym główną „gwiazdą” był Saturn. Przejęciu układu Saturna przez układ Słońca towarzyszyło pojawienie się przepięknej nowej komety, która w pewnym momencie zakłóciła ruchy planet. Zdaniem Velikovsky’ego te zakłócenia doprowadziły w końcu do bliskich spotkań między nimi, podczas których mogło dochodzić do gigantycznych międzyplanetarnych wyładowań elektrycznych. Zdaniem Velikovsky’ego mitologie wszystkich religii opisują ten sam scenariusz, w którym wydarzenia na niebie zinterpretowano jako wojnę bogów, po której na niebie zapanował nowy kosmiczny porządek. W swoich komentarzach do starożytnych przekazów zwraca on uwagę na spójność opisywanych zdarzeń pomimo ich fizycznego oddalenia oraz wykazuje, w jaki sposób pewne różnice w tych opisach mogą wynikać z położenia geograficznego obserwatorów.

W swojej kolejnej książce Earth in Upheaval (Ziemia we wstrząsach) prezentuje ogromną ilość rzeczowych dowodów potwierdzających katastroficzną narrację przedstawioną w starożytnych tekstach. Są to dowody w postaci struktur geologicznych oraz znalezisk paleontologicznych i archeologicznych. Śmiałość stawianych przez Velikovsky’ego hipotez była wynikiem jego przekonania o wartości ich prostoty. Velikovsky przewidział na przykład, że ze względu na stosunkowo niedawne „narodziny” Wenus na jej powierzchni musi panować bardzo wysoka temperatura. Przewidział też, że atmosfera Jowisza jest źródłem fal radiowych. W tamtym czasie były to niebywałe wręcz herezje. Jedni wyśmiewali jego przewidywania, a inni zaczęli mu wręcz ubliżać, ale żadnemu z jego krytyków nie przyszło do głowy, że ich trafność już w niedalekiej przyszłości poświadczą wyniki badań.

Mimo ogromnej fali krytyki poglądy Velikovsky’ego zainspirowały całą rzeszę ludzi. Powstały drukowane periodyki popularyzujące jego nowe podejście (np. miesięcznik Kronos jest wydawany w Wielkiej Brytanii do dzisiaj) oraz mnóstwo publikacji rozwijających wiele wątków niekiedy tylko wspomnianych w jego książkach.

ThunderboltsProject, czyli nowe spojrzenie

Podczas konferencji zorganizowanej przez Davida Talbotta (znanego badacza mitów o Saturnie) doszło do brzemiennego w skutkach spotkania. Ze względu na obecność Velikovsky’ego wziął w niej również udział australijski fizyk Wallace Thornhill (1942–2023). To wtedy Talbott i Thornhill mieli po raz pierwszy okazję wymienić się poglądami.

David Talbott

Podczas ponownego spotkania, które miało miejsce kilka lat później, Thornhill i Talbott zorientowali się, jak bardzo ich osiągnięcia wzajemnie się zazębiają i jak doskonale się uzupełniają. Po wielu długich i żarliwych dyskusjach doszli w końcu do wniosku, że nauka dojrzała do zmiany paradygmatu i że już wiedzą, na czym ma polegać nowy. Inicjatywę, którą wtedy zapoczątkowali, nazwali ThunderboltsProject. Ma ona na celu propagowanie idei, że to elektryczność leży u podstaw większości znanych nam procesów fizycznych. ThunderboltsProject jest do dziś prężnie działającą organizacją. Wydała kilka ciekawych książek, w tym dwie napisane wspólnie przez Thornhilla i Talbotta Thunderbolts of the Gods (Pioruny bogów) i The Electric Universe (Elektryczny wszechświat)] oraz The Electric Sky (Elektryczne niebo) Donalda Scotta. Na YouTube do dziś istnieje ich kanał.

Wallace Thornhill (1942–2023)

Petroglify i malowidła

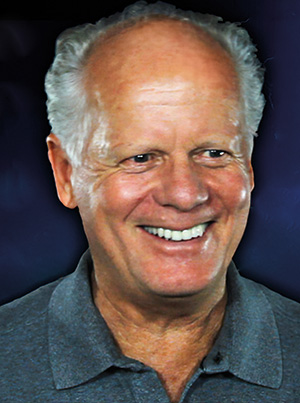

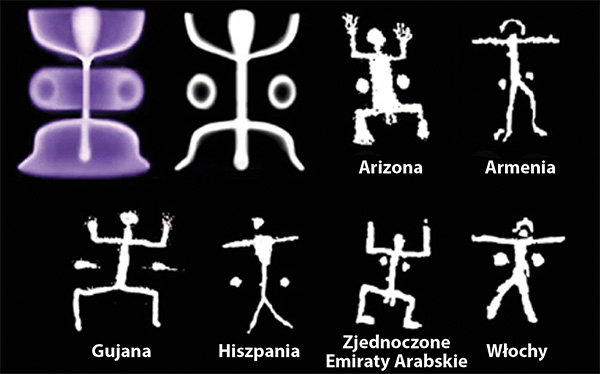

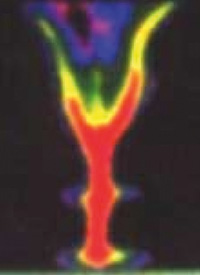

Gdy Anthony Peratt, fizyk plazmy z Los Alamos Laboratory (nota bene uczeń Hannesa Alfvena), zobaczył zdjęcia najczęściej powtarzających się motywów prehistorycznych petroglifów zwanych patykowymi ludzikami (patrz rycina 1), od razu rozpoznał w nich znane mu z laboratorium formacje plazmy. Ku jego zaskoczeniu okazało się również, że podobizny różnych formacji plazmy przedstawiano w sztuce na całym świecie i robiono to nie tylko w formie petroglifów. Pochodzące z rozmaitych kultur artystyczne malowidła i rzeźby przedstawiające boską broń jako kosmiczne pioruny wydają się być również wiernymi kopiami form, jakie tworzy plazma. Peratt zidentyfikował później wiele innych form plazmy, których symbole graficzne wyglądają dokładnie tak jak badane przez niego struktury plazmy (patrz ryciny 2 i 3).

Anthony Peratt

Ryc. 1. Rozpoznane przez Anthony’ego Peratta formacje plazmy w kształcie petroglifów przedstawiających patykowatych ludzi. Należy zwrócić uwagę na kropki, które nie stanowią części anatomii, a które widnieją na petroglifach znajdowanych w różnych częściach świata.

Ryc. 2. Ewolucja struktury plazmy obserwowana przez Anthony’ego Peratta w laboratorium.

Ryc. 3. Zdjęcie plazmy wykonane przy pomocy kamery termicznej.

[BREAK]

Elektryczne gwiazdy

Prawdziwie niezwykłym osiągnięciem ThunderboltsProjectu było zainicjowanie skomplikowanego eksperymentu laboratoryjnego, w którym testowano stworzony przez Ralpha Jurgensa elektryczny model Słońca. Według tego modelu w jądrze Słońca nie zachodzą reakcje termojądrowe, lecz jest ono zasilane z zewnątrz. W modelu tym na Słońce spływa ciągły strumień elektronów. Są to elektrony z przestrzeni wokółsłonecznej o średnicy prawie 3 lat świetlnych, które w miarę zbliżania się do Słońca gęstnieją, by nad samą jego powierzchnią uformować sferyczny łuk elektryczny tworzący fotosferę. Zebrano więc zespół naukowców, znaleziono prywatnych sponsorów i badania ruszyły pod nazwą Project SAFIRE (Stellar Atmosferic Function in Regulation Experiment – funkcja atmosfery gwiazdowej w eksperymencie regulacyjnym). W celu symulacji tego procesu w dość dużej komorze próżniowej umieszczono całą baterię ruchomych instrumentów pomiarowych, a w samym środku elektrodę (anodę) w kształcie niewielkiej kuli. Po kilku latach badań zachowania plazmy w takiej konfiguracji naukowcy ogłosili, że przeprowadzone eksperymenty „nie wykazały sprzeczności” obserwacji z przewidywaniami modelu elektrycznego. Co więcej, w czasie eksperymentów na powierzchni anody zaobserwowano pojawianie się pierwiastków, których wcześniej w komorze nie było. Według eksperymentatorów świadczy to o tym, że reakcje przemiany pierwiastków wcale nie muszą zachodzić we wnętrzach gwiazd, lecz dzieje się to w ich fotosferze.

Elektryczny model gwiazd jest o tyle ciekawy, że w prosty sposób wyjaśnia wiele związanych ze Słońcem zagadek. W modelu tym całkiem naturalne jest na przykład to, że temperatura fotosfery jest o wiele niższa niż temperatura korony słonecznej (jest to tak zwana anomalia rozkładu temperatury). Nie ma niczego dziwnego również w tym, że jony wiatru słonecznego mogą przyśpieszać w miarę oddalania się od Słońca, ani w tym, że atmosfera słoneczna na wysokości równika obraca się szybciej niż w pobliżu biegunów. Model grawitacyjny nie dość, że nie przewidywał tego typu efektów, to na dodatek ma duże problemy z wyjaśnieniem tych zagadek. Dla przykładu w celu wyjaśnienia anomalii rozkładu temperatury w sąsiedztwie Słońca model grawitacyjny ucieka się do mechanizmu tak zwanej „rekonekcji” zerwanych linii sił pola magnetycznego. Problem z tym mechanizmem polega na tym, że linie sił pola magnetycznego nie są fizycznymi bytami. Pole magnetyczne zmienia się w sposób ciągły i nie występują w nim żadne „linie”. Wąskie łukowate paski, które obserwujemy na przykład na kartce papieru z wysypanymi na nią opiłkami żelaza, powstają w wyniku samoorganizacji ułożenia tych opiłków w obecności pola magnetycznego. Linie te rysuje się też w celu zobrazowania kształtu magnetosfery wokół magnesu, ale traktowanie ich jako fizycznych bytów świadczy chyba o stopniu desperacji teoretyków.

Geologia

Dopuszczenie możliwości występowania wyładowań elektrycznych również w skali kosmicznej w sposób fundamentalny zmienia podejście do zagadnień geologii. Okazuje się bowiem, że wiele wielkoskalowych struktur geologicznych może być wynikiem procesów towarzyszących wyładowaniom elektrycznym uderzającym w powierzchnię planet. Należą do nich: jonizacja (w wyniku której neutralne cząstki zostają rozbite na jony), erozja elektryczna (w wyniku której następuje gwałtowne stopienie i odrzucenie stopionego materiału) i siła elektromotoryczna (która towarzyszy każdemu przepływowi prądu). W wyniku takiego uderzenia w zależności od energii wyładowania część materiału zostaje odparowana, a część stopiona, przeobrażona chemicznie i odrzucona na zewnątrz. W czasie takich uderzeń powstają różnej wielkości zastygłe odpryski stopionego materiału i okruchy skalne. Pod wpływem przepływu silnego prądu elektrycznego w skałach powstają żyły różnych minerałów i konglomeraty metali, a w miejscach kontaktu łuku elektrycznego z gruntem powstają kratery łudząco podobne do kraterów uderzeniowych. Zdaniem propagatorów nowego paradygmatu kratery na innych ciałach niebieskich są w ogromnej większości pochodzenia elektrycznego. Świadczyć ma o tym niemal kompletny brak kraterów owalnych (powstających gdy meteoryt uderza pod pewnym kątem) oraz częste występowanie kraterów wtórnych na krawędziach większych kraterów. Wiemy, że kratery wtórne obserwowane w laboratorium podczas obróbki elektrycznej są zjawiskiem powszechnym i powstają prawie zawsze na krawędziach kraterów głównych. Prawdopodobieństwo uderzenia meteoru w krawędź krateru innego meteoru jest bardzo małe. Prawdopodobieństwo wielu takich uderzeń jest nieporównanie mniejsze. A jednak kratery takie występują na innych planetach i księżycach bardzo często.

Dowodem na nieadekwatność teorii uderzeniowej jest ogromny krater na powierzchni marsjańskiego księżyca Fobosa. Jest on o wiele za duży aby mógł powstać w wyniku uderzenia, które musiałoby w takim wypadku całkowicie zniszczyć Fobosa.

Teoria elektryczna dostarcza też bardzo ciekawą hipotezę na temat powstawania głębokich kanionów. Już Velikovsky zwrócił uwagę, że kształt Wielkiego Kanionu Kolorado jest tzw. wzorem Lichtenberga. Wzory Lichtenberga powstają, gdy prąd elektryczny znajduje sobie drogę przez jakieś ciało stałe. Zdaniem Velikovsky’ego Wielki Kanion powstał w wyniku uderzenia w Ziemię międzyplanetarnego pioruna, do którego doszło podczas bliskiego spotkania Ziemi z Marsem lub z Wenus. Jako dowód, że Wielki Kanion nie został wydrążony przez działanie wody Velikovsky podaje brak gigantycznej delty, jaką powinna utworzyć rzeka Kolorado z materiału wypłukanego z Kanionu. Materiał ten powinien zostać gdzieś zdeponowany, ale nikt nie wie, gdzie on jest. Niewielkie równiny zalewowe spotykane wzdłuż tej rzeki są zbyt małe aby pomieścić ogromne ilości skał, jakie musiałyby być wypłukane z największego kanionu na świecie.

Skutki uderzenia międzyplanetarnego pioruna nie ograniczałyby się do tworzenia Wielkich Kanionów. Wyładowaniom o takiej skali towarzyszyłyby ponaddźwiękowe wiatry oraz długotrwałe wstrząsy sejsmiczne kruszące grunt i zamieniające wszelkie pokłady kruszywa w tańczącą i powyginaną w rytm magnetycznych pulsów ciecz. Porwane przez supersoniczne wiatry cząstki skał, zderzając się z jakimikolwiek przeszkodami, przyklejałyby się do nich, tworząc coraz to nowe warstwy dokładnie posegregowane przez zmieniające się drastycznie pole elektromagnetyczne. Tego typu procesy są gwałtownym zaprzeczeniem powolnej sedymentacji, wypiętrzania i erozji, a jednak jak sprawdzono w laboratorium, prowadzą do tworzenia struktur niemal identycznych z wieloma formacjami geologicznymi (kratery, kaniony, łańcuchy górskie, a nawet struktury znane z kultowej Monument Valley w Arizonie).

Ryc. 4. Greckie reprezentacje boskiego pioruna.

Implikacje

W artykule przedstawiony jest tylko wąski wycinek ciągle powiększającego się zbioru nowych idei wynikających z elektrycznego paradygmatu. W rzeczywistości jest ich o wiele więcej i prezentacja całej ich listy byłaby wręcz niemożliwa. Widać jednak wyraźnie, że odrzucenie istniejących dogmatów naukowych stało się silnym bodźcem dla rozwoju wielu ciekawych koncepcji naukowych. Z nowego spojrzenia wyłania się zupełnie inny, spójniejszy i pełniejszy obraz wszechświata. Wszechświata, w którym planety, gwiazdy, galaktyki i gromady galaktyk nie są odrębnymi wyspami, lecz połączonymi prądami Birkelanda złożonymi strukturami przypominającymi komórki żywego organizmu. W ramach elektrycznego wszechświata nie pojawia się rozdźwięk między starożytnymi przekazami różnych kultur, a tym, co wiemy o Ziemi i kosmosie. Wręcz przeciwnie, okazuje się, że mity są cennym źródłem informacji na temat naszej historii, która w rzeczywistości jest o wiele ciekawsza, niż nas uczono w szkole.

Jest rzeczą zrozumiałą, że establishment naukowy w obawie o swoją reputację sprzeciwia się publikowaniu wszystkiego, co wyprodukują niesforni akademicy. Niestety, obiekcje te z czasem sprawiły, że do publikacji dopuszcza się wyłącznie to, co jest zgodne z przekonaniami establishmentu. Żadna teoria nie powinna decydować, które obserwacje warto przeprowadzać, a które można ignorować. Żadna teoria nie powinna też dyktować, jakie inne teorie powinniśmy odrzucić, bo o tym powinny decydować eksperymenty testujące każdą z nich, a nie tylko te wybrane. Dopóki ktoś chce poświęcić swój czas i karierę na jakieś badania, dopóty nie powinno mu się blokować dostępu do instrumentów zbudowanych za pieniądze podatników. Nie powinno być tak, że o kosmologii można rozmawiać tylko w kontekście wielkiego wybuchu albo o geologii tylko w kontekście uniformitaryzmu. Różnice poglądów powinny być w nauce normą, a każdy nacisk na zgodę w jakiejkolwiek kwestii powinien być traktowany z podejrzliwością. Popularyzacja nauki nie musi się przecież skupiać na prezentacji tego, co wiemy, bo to, czego nie wiemy, jest o wiele bardziej interesujące. Natomiast pokora wobec złożoności wszechświata powinna nam ciągle przypominać, że zawsze możemy się mylić.

O autorze:

Tomasz Zaborowski jest entuzjastą nauki interesującym się tym, co dzieje się na jej obrzeżach. Od wielu lat śledzi badania nad nowym paradygmatem nauki znanym jako Elektryczny Wszechświat, co zaowocowało napisaniem przez niego niewydanej jeszcze książki na ten temat. Z autorem skontaktować się można pisząc na adres poczty elektronicznej tzaborowskim@gmail.com.